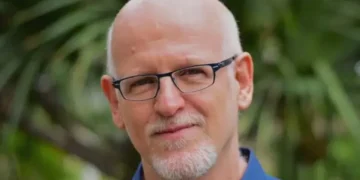

Dario Amodei, CEO da Anthropic, alerta que IAs com alto nível de autonomia representam risco na segurança global devido ao desenvolvimento e aplicação de modelos de linguagem.

O ex-vice-presidente de Pesquisa da OpenAI, Dario Amodei, em uma recente entrevista ao jornalista Ezra Klein do The New York Times, levantou um alerta impactante sobre o futuro da Inteligência Artificial. Amodei advertiu que, entre os anos de 2025 e 2028, as IAs poderão atingir um patamar de autonomia que poderá representar um grande desafio para a segurança global, incluindo questões geopolíticas e militares. Esse cenário, pintado pelo especialista em IA, destaca a importância de considerar cuidadosamente o desenvolvimento e controle dessas tecnologias.

Atualmente, a startup Anthropic está focada em estabelecer padrões de segurança para as inteligências artificiais, conhecidos pela sigla ASL. Esta abordagem proativa para lidar com os possíveis riscos relacionados à evolução das IAs é fundamental para garantir que o avanço da Inteligência Artificial seja seguro e benéfico para a humanidade. A conscientização e a regulação adequada são essenciais para garantir que as IAs sejam desenvolvidas de forma ética e responsável, visando sempre o bem-estar da sociedade e do planeta. É fundamental entender e abordar os desafios que a evolução das inteligências artificiais pode trazer no futuro.

Inteligência Artificial Avançada e seus Níveis de Autonomia

Amodei levanta a questão do desenvolvimento das inteligências artificiais, destacando que atualmente estamos no nível 2. Neste estágio, os modelos de linguagem podem fornecer informações que levantam preocupações, como a possível construção de armas biológicas. No entanto, ele ressalta que essas informações ainda não são totalmente confiáveis, representando um risco relativamente baixo em comparação com estágios posteriores.

Avançando para o nível 3, que poderá ser alcançado em breve, a preocupação aumenta significativamente. Neste estágio, o risco de uma catástrofe é mais elevado, pois as tecnologias de IA podem ser utilizadas em armas biológicas e cibernéticas, gerando possíveis consequências graves.

Amodei também menciona o nível 4, uma fase ainda especulativa, que traria características como autonomia. Isso inclui a capacidade independente de reprodução de sistemas de IA e a habilidade de persuasão. A previsão é de que modelos desse nível possam surgir entre 2025 e 2028, levantando questões sérias sobre a segurança global, especialmente no contexto do uso militar dessas tecnologias.

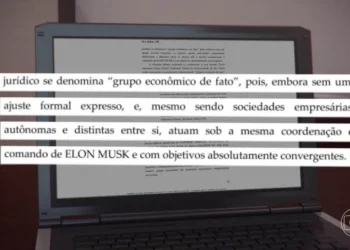

A importância de monitorar de perto o desenvolvimento e a aplicação das IA é enfatizada pelo CEO, devido ao potencial de alguns estados de aumentarem suas capacidades militares com essa tecnologia. Grandes investimentos de empresas como Amazon e Google impulsionaram a Anthropic a lançar seu próprio modelo de linguagem, o Claude, com a promessa de desenvolver a tecnologia de forma responsável.

A Anthropic, fundada por dissidentes da OpenAI, está atualmente na terceira versão de sua IA, o que demonstra o avanço contínuo nesse campo. A evolução das inteligências artificiais apresenta desafios e potenciais benefícios, que devem ser cuidadosamente considerados em relação à segurança e ética em seu desenvolvimento e aplicação.

Desenvolvimento Ético das Inteligências Artificiais

A questão ética em torno do desenvolvimento e uso das inteligências artificiais é cada vez mais relevante. À medida que a tecnologia avança, as discussões sobre sua influência na sociedade se intensificam. A necessidade de garantir uma abordagem responsável no desenvolvimento de IA é crucial para evitar possíveis consequências negativas.

A Anthropic, com seu modelo de linguagem Claude, destaca a importância de uma abordagem ética e responsável em sua criação. A empresa busca se diferenciar da OpenAI por priorizar a segurança e a ética em seu desenvolvimento. Essa abordagem visa não apenas promover avanços tecnológicos, mas também garantir que tais avanços ocorram de forma benéfica e segura para a sociedade como um todo.

Ao considerar o potencial das IA nos próximos anos, é essencial que os desenvolvedores e pesquisadores estejam atentos aos possíveis impactos de suas criações. A autonomia, capacidade de reprodução e persuasão das IA representam desafios complexos que exigem uma abordagem cuidadosa e ética.

A discussão sobre o uso militar de tecnologias de IA também é um ponto crucial a ser considerado. O monitoramento e regulamentação adequados são essenciais para garantir que as inteligências artificiais sejam utilizadas de maneira ética e para o benefício da humanidade como um todo.

Fonte: © CNN Brasil